如何用Docker高效部署AI:机器学习模型全流程指南

一、Docker在机器学习场景中的核心价值

在传统机器学习开发中,环境配置是制约项目推进的首要难题。不同开发者的操作系统差异、Python版本冲突、依赖库版本不兼容等问题,常导致”在我机器上能运行”的经典困境。Docker通过容器化技术,将应用及其依赖环境打包为独立镜像,解决了这一核心痛点。

在传统机器学习开发中,环境配置是制约项目推进的首要难题。不同开发者的操作系统差异、Python版本冲突、依赖库版本不兼容等问题,常导致”在我机器上能运行”的经典困境。Docker通过容器化技术,将应用及其依赖环境打包为独立镜像,解决了这一核心痛点。

这次要介绍的 AI 项目在 Github 高达 53.9k,它可以免费使用 GPT-3.5、GPT4、Llama、gemini-pro 等等19种大模型,简直恐怖如斯!!它就是 gpt4free,github 地址。

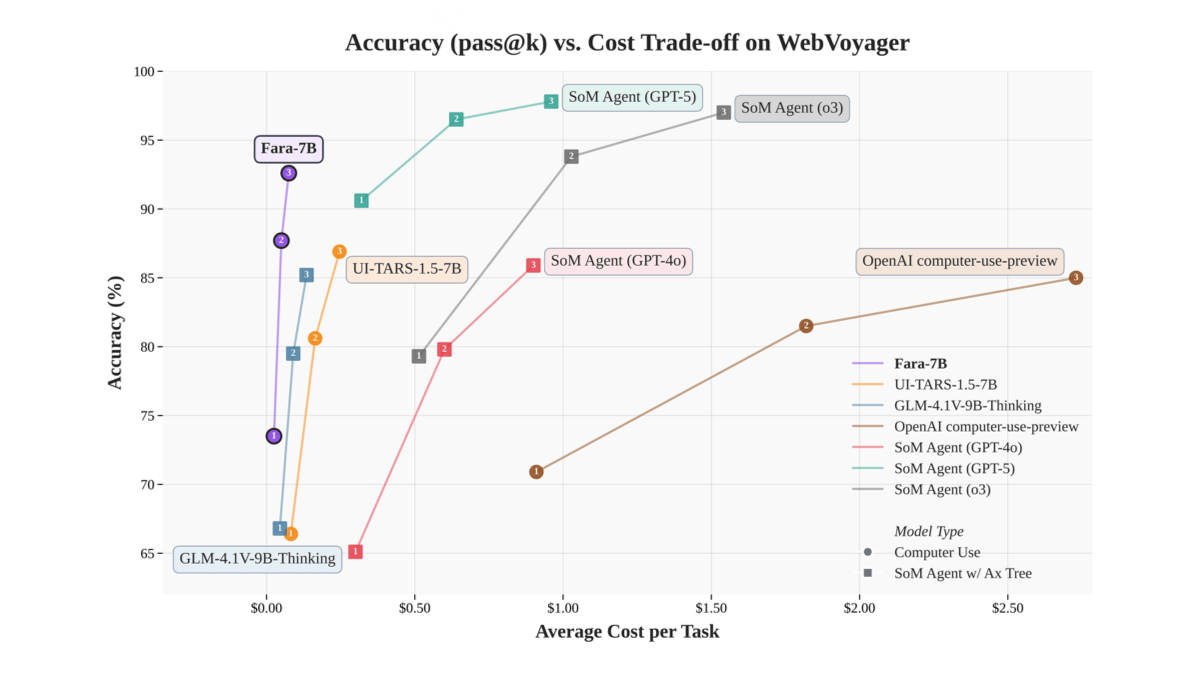

Fara-7B is Microsoft's first agentic small language model (SLM) designed specifically for computer use. With only 7 billion parameters, Fara-7B is an ultra-compact Computer Use Agent (CUA) that achieves state-of-the-art performance within its size class and is competitive with larger, more resource-intensive agentic systems.

微软研究院悄然推进了设备端人工智能的一个里程碑:Fara-7B,一个拥有 70 亿参数的智能小型语言模型 (SLM),旨在通过预测鼠标和键盘操作来查看网页和操作电脑,现在它已作为开源研究成果提供,供用户进行实践实验。

HunyuanOCR是腾讯混元团队开源的高性能光学字符识别模型,参数量仅10亿。基于混元多模态架构开发,采用端到端设计,能高效处理文字检测、识别及文档解析任务。模型在复杂文档测试中得分94.1分,超越谷歌Gemini3-Pro等主流产品,支持14种小语种翻译。轻量化特性适用于票据识别、视频字幕提取等场景,开源地址为GitHub和Hugging Face平台。

Fara-7B是微软开源发布的70亿参数规模的计算机操作代理(CUA)模型,基于Qwen2.5-VL-7B架构。通过视觉解析网页截图,在屏幕上执行点击、输入等操作,无需依赖额外的可访问性树或多个大模型协作,可直接在Windows 11本地运行,支持NPU加速,实现更低延迟和更好的隐私保护。Fara-7B在WebVoyager、Online-Mind2Web等公开基准测试中表现优异,任务成功率高,部分任务领先同级模型。采用全新的合成数据生成流程进行训练,包含大量任务轨迹和辅助任务数据,以监督微调为主。